1. Ollama 介绍

1.1 Ollama 的核心功能

Ollama 是一款专为本地化运行大型语言模型(LLM)设计的开源工具,通过简化的命令行操作和 API 接口,让用户无需复杂配置即可在个人电脑上部署和运行各类开源大模型。

1.1.1 一键部署模型

- 支持通过

ollama run <模型名>命令直接拉取并运行模型(如qwen、DeepSeek等),自动处理模型下载、格式转换和环境适配。 - 内置模型仓库(Model Hub):提供数百个预量化模型,覆盖 7B 到 70B 参数规模。

1.1.2 本地化运行

完全离线运行,无需网络连接,数据隐私性高。支持 CPU/GPU 混合计算(通过 Metal、CUDA 或 OpenCL 加速),显存不足时可自动切换到内存运行。

1.1.3 开发者友好接口

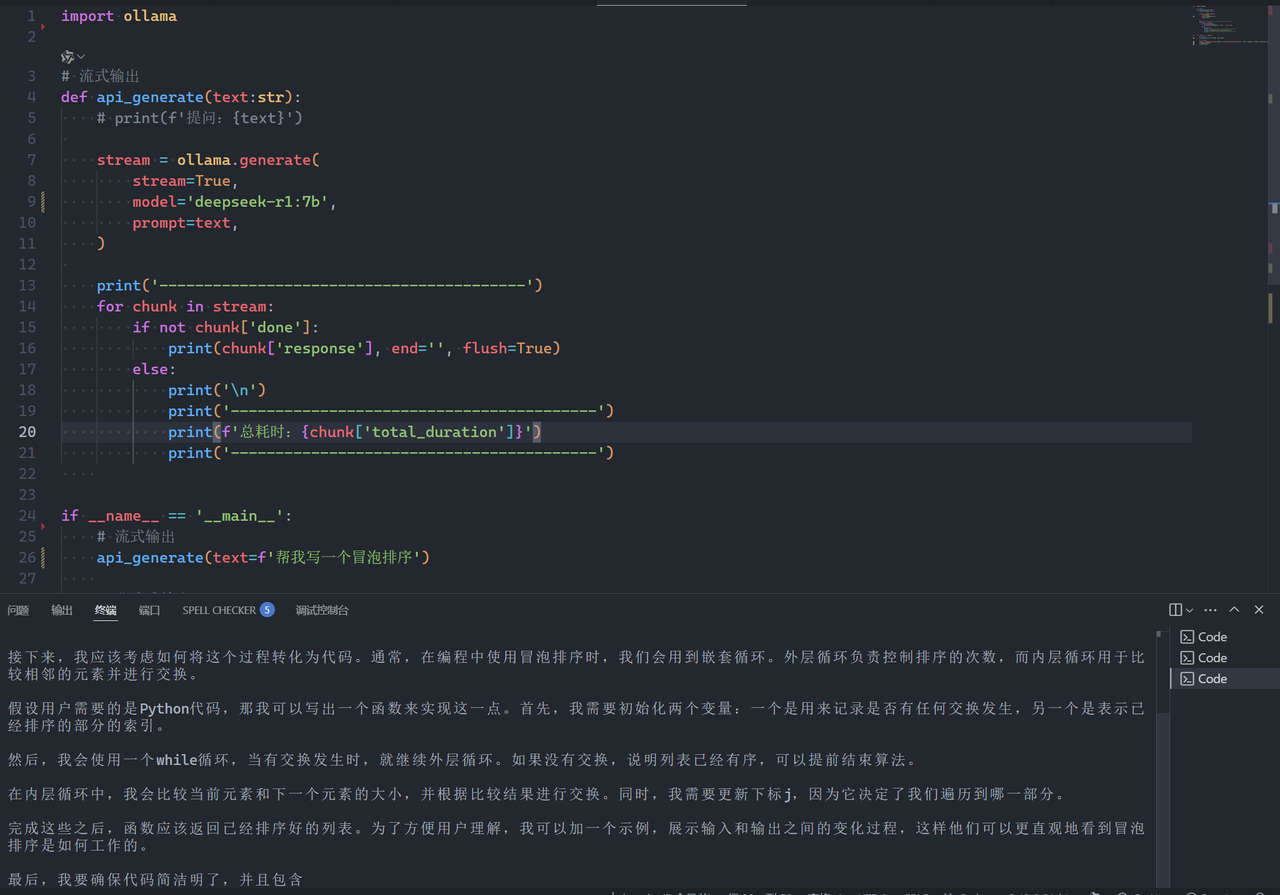

- 提供 REST API(默认端口

11434),轻松与第三方应用(如 Chatbox、Dify)集成。

- 支持 Python/JavaScript 等语言的 SDK,便于二次开发。

1 | import ollama |

1.2 Ollama 的技术优势

1.2.1 模型轻量化

- 采用 GGUF 量化技术(如 Q4、Q5、Q8),在保持模型精度的同时显著降低资源占用:

- 7B 模型仅需 4-6GB 内存/显存

- 13B 模型占用 8-10GB

- 70B 模型需 32GB 以上(需高端显卡)

1.2.2 跨平台兼容性

- 支持 Windows/macOS/Linux 系统

- 自动适配 NVIDIA/AMD/Apple Silicon 芯片

1.2.3 灵活扩展性

- 支持自定义模型(通过 Modelfile 定义参数、提示词模板)

- 可导入 HuggingFace、PyTorch 等开源模型格式

1.3 Ollama 支持的主流模型

| 模型类型 | 代表模型 | 典型用途 |

|---|---|---|

| 通用对话 | Llama3、DeepSeek R1、Mistral | 问答、写作、编程 |

| 代码生成 | CodeLlama、StarCoder | 代码补全、算法实现 |

| 多模态 | LLaVA、Bakllava | 图像理解、图文问答 |

| 垂直领域 | Meditron(医疗)、FinGPT | 专业领域知识处理 |

2. Chatbox 介绍

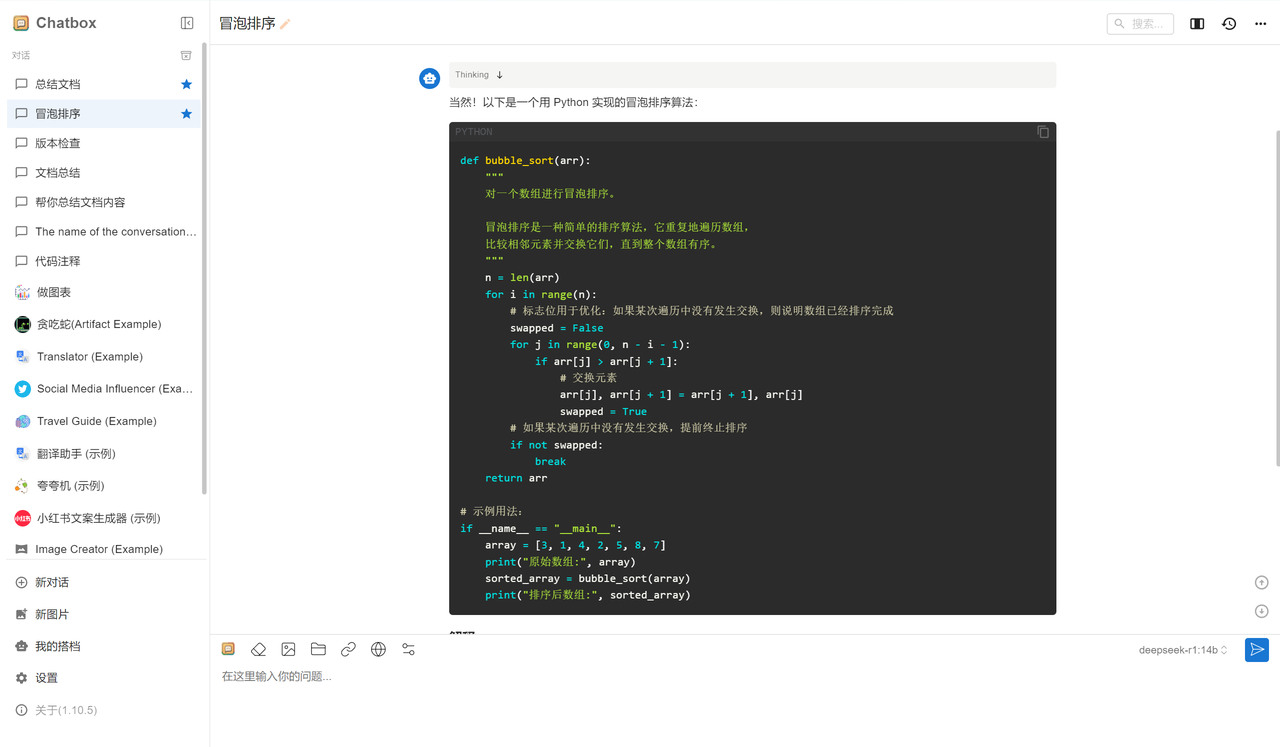

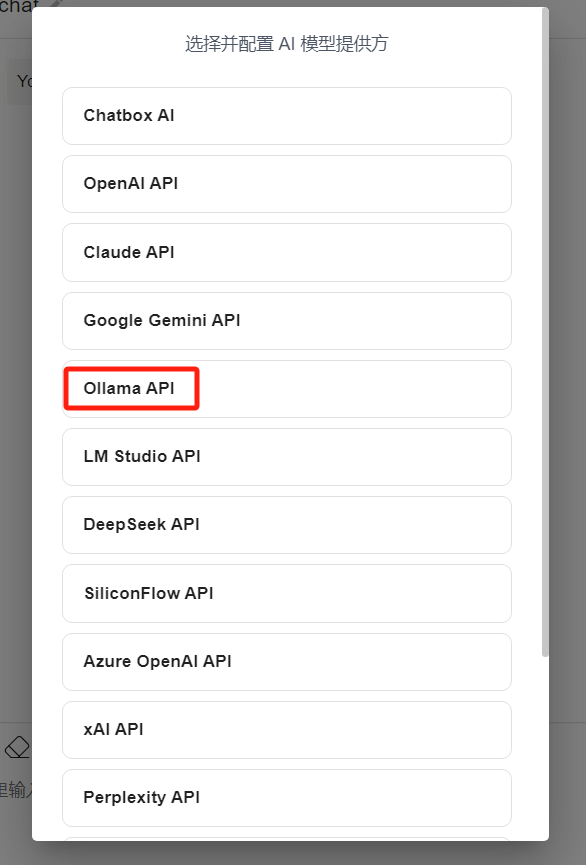

Chatbox 是一款开源免费的 AI 对话客户端,专为本地或云端大语言模型(LLM)提供可视化交互界面。它支持与 Ollama、OpenAI、Claude 等模型 API 无缝对接,尤其适合需要隐私保护或离线运行 AI 的用户。

2.1 核心功能亮点

2.1.1 零代码可视化操作

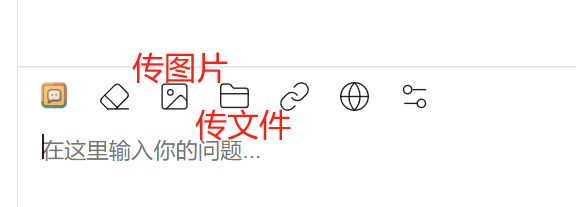

- 提供简洁的聊天式界面,

无需编程基础即可与本地模型对话(如 DeepSeek、Llama3)。 支持 Markdown 渲染,代码高亮显示,对话历史自动保存。

2.1.2 多模型兼容性

- 支持 Ollama 本地 API,也兼容 OpenAI、Anthropic 等云端服务。

- 可同时管理多个模型账户,一键切换不同 AI 角色。

2.1.3 隐私与安全

数据完全本地存储,对话记录不经过第三方服务器。- 支持敏感内容过滤和自定义安全策略(如禁用某些话题)。

2.1.4 高级功能

预设提示词库:内置常用提示词模板(如翻译、写作助手、代码生成等),支持自定义模板。快捷指令:可设置快捷键快速触发常用操作。调试模式:开发者可通过调试面板查看 API 请求与响应的原始数据。系统提示词:自定义系统级提示词,调整 AI 的行为模式。

2.2 与同类工具对比

| 特性 | ChatBox | LobeChat | Open WebUI |

|---|---|---|---|

| 核心定位 | 轻量本地客户端 | 多功能跨平台助手 | 自托管 Web UI(类 ChatGPT 界面) |

| 部署方式 | 桌面安装 | Web/桌面/移动端 | 需自托管(Docker/本地服务器) |

| 开源/免费 | ✅ 开源免费 | ✅ 开源免费 | ✅ 开源免费 |

| 隐私控制 | 本地存储(无需网络) | 可选本地/云端 | 自托管(完全控制数据) |

| 内置模型支持 | ❌ 需自备 API | ✅ 多模型直接使用 | ❌ 需自备 API 或本地模型 |

| 多会话管理 | 标签页式 | 文件夹分类 | 线性对话历史 |

| 插件生态 | 基础插件 | ✅ 丰富插件 | 有限(依赖社区扩展) |

| 团队协作 | ❌ 个人 | ✅ 团队共享 | ❌ 个人或单用户 |

| 移动端支持 | ❌ 无 | ✅ PWA/响应式 Web | ✅ 通过浏览器访问 |

| 开发者工具 | ✅ 调试模式/API 日志 | ❌ 普通用户导向 | ✅ 高级模型参数配置 |

| 自托管复杂度 | ❌ 无需托管 | ❌ 无需托管 | ✅ 需技术部署(适合极客/企业) |

| 特色功能 | 系统级提示词/快捷键 | 知识库检索/AI 画图 | 本地模型集成/高自由度 UI 定制 |

总结选择建议

ChatBox:适合开发者/隐私敏感用户,轻量本地化,快速调试提示词。LobeChat:适合普通用户/团队协作,开箱即用多模型,功能丰富易扩展。Open WebUI:适合自托管需求者/企业,完全控制数据,兼容本地 AI 模型(如 Llama3)。

3. 部署 DeepSeek R1 7B 模型(基于 Ollama)

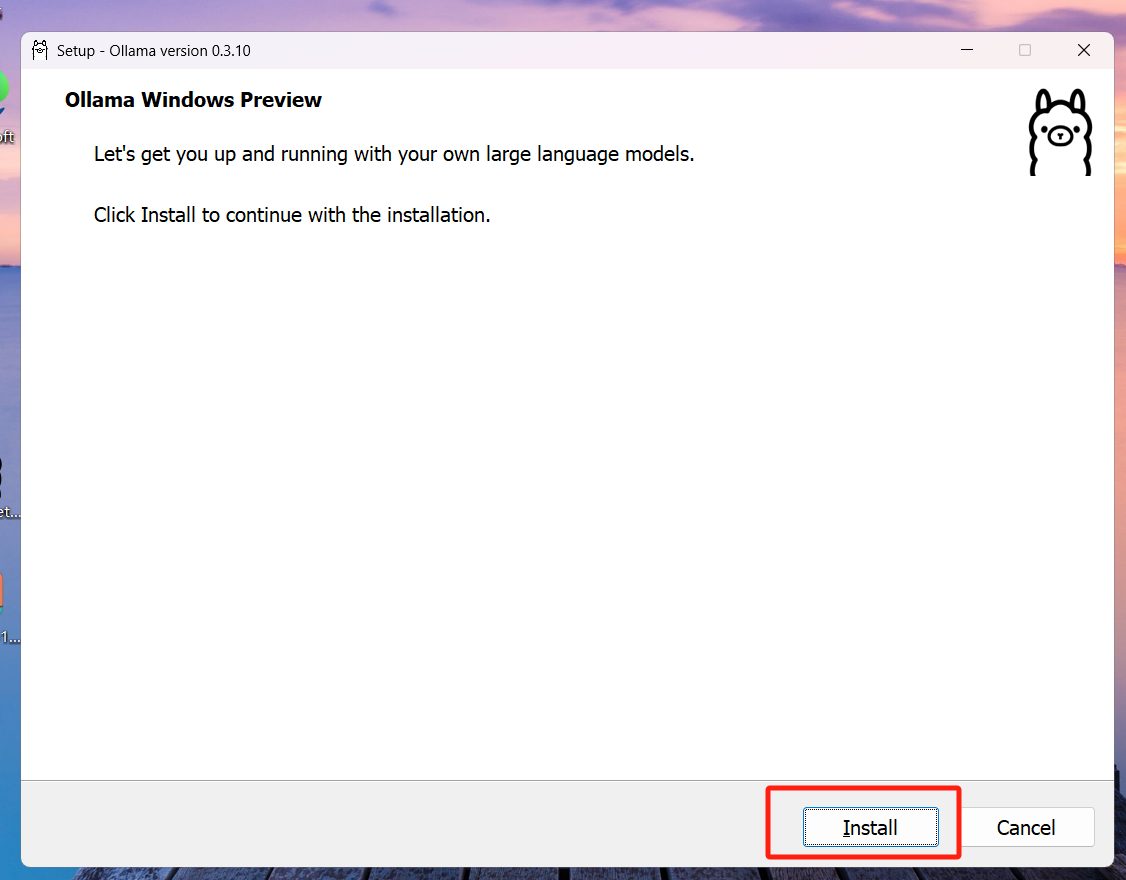

3.1 安装 Ollama

Windows:访问 Ollama 官网,下载对应系统的安装包,双击运行并完成安装。

验证安装:打开终端(或者cmd),输入命令ollama -v,若显示版本号则安装成功。

Linux:执行命令一键安装:1

2curl -fsSL https://ollama.com/install.sh | sudo bash

sudo systemctl start ollama

3.2 下载 DeepSeek R1 7B 模型

在终端输入以下命令拉取模型:

1

ollama run deepseek-r1:7b

进度查看:终端会显示下载进度条,出现 Success 即表示完成。

3.3 验证模型运行

- 下载完成后,终端会自动进入交互模式,输入测试问题(如“9.8 和 9.11 哪个更大?”),若模型返回逻辑清晰的回答,则部署成功。

3.4 (可选)自定义配置

- 修改模型存储路径(避免占用 C 盘):

Windows:在终端执行setx OLLAMA_MODELS D:\OllamaModels,重启生效。

4. 安装 Chatbox 实现可视化界面

4.1 下载 Chatbox 客户端

- 访问 Chatbox 官网,下载对应系统的安装包并完成安装。

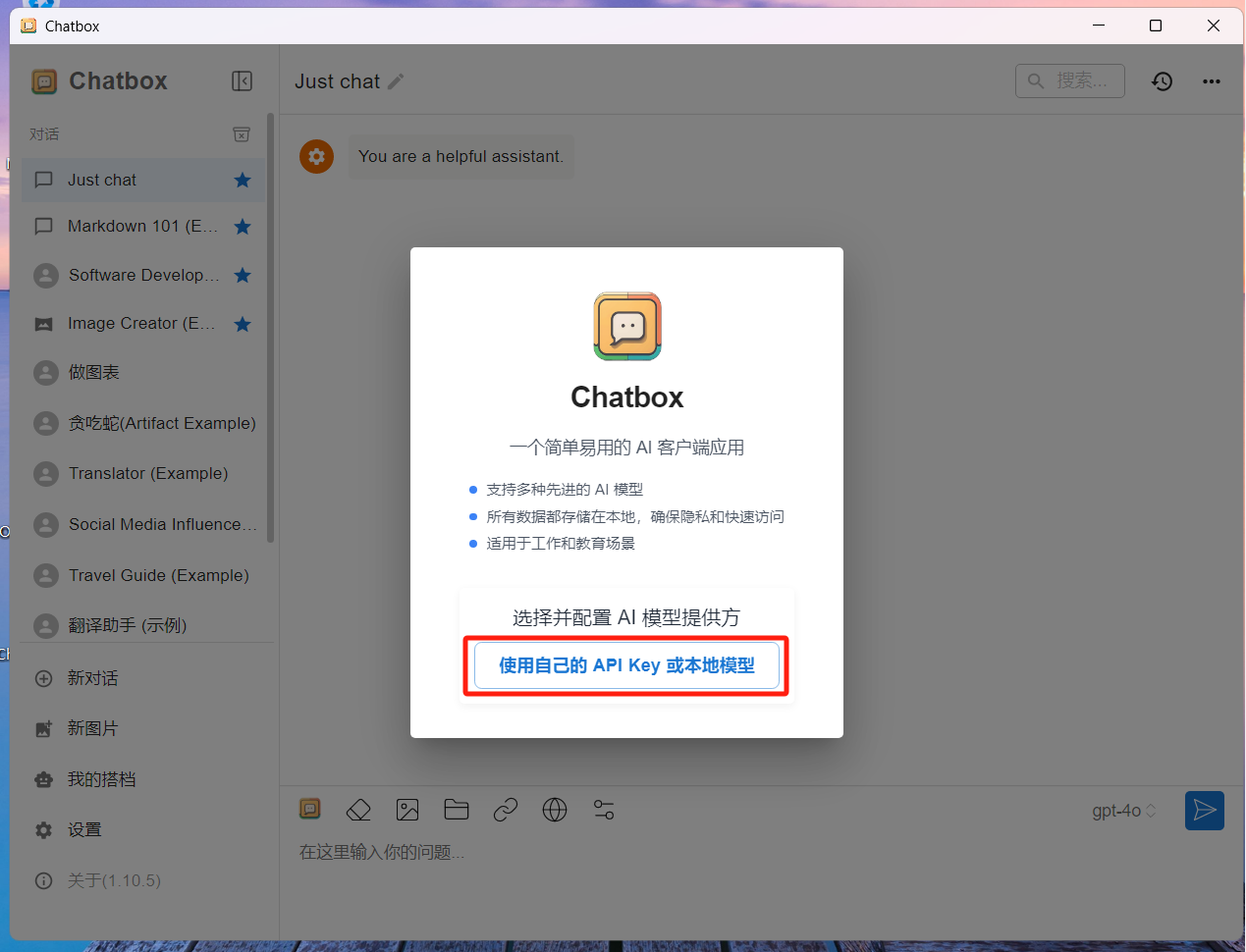

4.2 配置 Chatbox 连接 Ollama

- 打开 Chatbox,点击“使用自己的 API Key 或本地模型”。

- 在模型提供方中选择“Ollama API”。

- 填写 API 地址:默认端口(http://localhost:11434)。

- 在模型选择中勾选

deepseek-r1:7b,点击保存。

4.3 开始对话

- 返回主界面,输入问题(如“用 Python 写快速排序”),Chatbox 会通过本地模型生成回答。

课后作业

在自己的电脑上面部署 Ollama + DeepSeek + Chatbox。